|

近年来,国产AI大模型DeepSeek在人工智能领域迅速崛起,其卓越的性能和市场表现引发了广泛关注。DeepSeek不仅在数学运算、代码编写和中文知识问答等方面超越了ChatGPT-4,还凭借其高性价比的API服务价格调整,进一步巩固了其在市场中的地位。其创始人也因此有望跻身全球富豪榜,成为中国AI产业蓬勃发展的标志性人物。

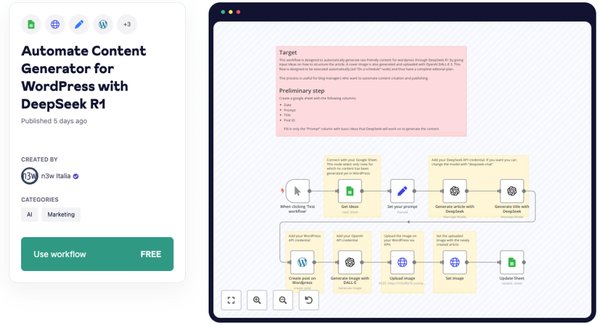

DeepSeek-R1作为一款强大的大语言模型,其本地化运行能力为开发者提供了极大的灵活性。通过与n8n框架的集成,开发者可以轻松构建高效的AI Agent,无需依赖外部API或云服务器。以下是实现这一集成的关键步骤: 1. 安装n8n与Ollama首先,开发者需要在本地环境中安装n8n框架和Ollama工具。n8n是一个强大的自动化工作流工具,而Ollama则是运行大语言模型的本地化解决方案。 2. 下载DeepSeek-R1模型通过Ollama,开发者可以下载不同规模的DeepSeek-R1模型。例如:

7B参数模型:适合大多数CPU和NVIDIA GPU

1.5B参数模型:适合低端硬件

14B或70B参数模型:适合高端GPU 3. 配置n8n工作流在n8n中,开发者可以通过简单的拖拽操作构建聊天链。具体步骤包括:

添加“On chat message”模块,用于接收用户输入

配置“Basic LLM Chain”模块,选择Ollama作为聊天模型

选择DeepSeek-R1模型并启动聊天功能 4. 运行与测试完成配置后,开发者可以在本地环境中运行AI Agent,并通过n8n的图形界面与DeepSeek-R1进行交互。

DeepSeek-R1的强大能力使其在多个领域表现出色:

数学运算:高效解决复杂数学问题

代码编写:生成高质量的代码片段

中文知识问答:提供准确的中文信息检索

本地化AI Agent:通过n8n集成,实现高效的自动化工作流 未来展望DeepSeek-R1的成功不仅展示了中国AI技术的实力,也为全球开发者提供了更多选择。随着本地化AI Agent的普及,DeepSeek有望在更多领域发挥其潜力,推动AI技术的进一步发展和应用。 (责任编辑:) |